当大语言模型的参数规模以指数级增长,如何高效训练这些“庞然大物”成为AI领域最紧迫的挑战之一。混合专家模型(Mixture of Experts,MoE)以其在计算效率与模型容量间的精妙平衡,正成为构建超大规模神经网络的核心架构。然而,MoE模型引入的复杂路由机制,特别是token分发与聚合阶段密集的跨机大数据量通信,往往成为制约训练效率的关键瓶颈。在这一背景下,昇思MindSpore开源社区即将于2025年12月25日在杭州举办的昇思人工智能框架峰会上,将首次系统性地揭秘其针对MoE大模型训练的深度优化方案,这些技术已在DeepSeek V3 671B等超大规模模型训练中展现出显著成效。

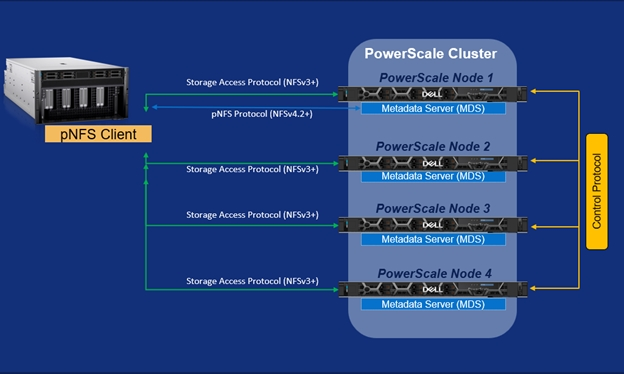

MoE架构的魅力在于它能够在不显著增加计算负担的情况下,大幅提升模型容量。通过引入多个“专家”网络,每个输入token仅被路由到少数专家进行处理,而非激活整个模型的所有参数。这种稀疏激活的特性,使得模型在保持高容量的同时,大幅降低了单次前向传播的计算量。然而,这种设计也带来了新的挑战:在分布式训练环境中,当专家被切分到不同计算节点上时,token的分发与聚合需要进行密集的AlltoAll跨机通信,而机间通信带宽通常远低于机内带宽,这就形成了训练流程中的性能瓶颈。

昇思MindSpore团队针对这一业界难题,提出了一套系统性的MoE性能优化方案,主要包括机间通信合并、零冗余通信、AlltoAllV收发异构复用等三项关键技术。这些技术协同作用,从不同维度攻克了MoE架构在大规模分布式训练中面临的通信开销大、断流频率高、显存占用高等核心瓶颈。

机间通信合并技术直指MoE训练中最棘手的通信瓶颈问题。在当前的流行MoE架构中,如DeepSeek V3每个层的路由专家个数高达256个。在训练实践中,为了减小显存压力,通常会开启专家并行(EP),将专家切分到不同的计算卡上。然而,当专家并行数大于单个节点的NPU/GPU数量时,专家会被切分到不同节点上,在token分发和聚合阶段,需要进行AlltoAll的机间通信。由于机间带宽远小于机内带宽,这一通信环节不可避免地成为整体性能的瓶颈。

针对这一挑战,昇思MindSpore团队创造性地采用了跨机AllGather通信与机内AlltoAll通信相结合的方式。该方案首先将所需的tokens通过跨机AllGather同步到机间,然后在机内进行tokens的排序与AlltoAll通信。基于这种分层通信策略,显著降低了跨机通信的数据量,有效提升了整体通信性能。经在DeepSeek V3 671B模型实训测试,在专家并行度为16时,端到端吞吐性能提升了15%。这一改进对于需要长时间训练的超大规模模型而言,意味着可观的训练时间节省与计算资源优化。

AlltoAllV收发异构复用技术则解决了另一个关键性能问题——通信算子下发过程中的断流现象。在MoE的token分发以及聚合阶段,各需要执行一次AlltoAllV的通信计算。传统实现中,在下发AlltoAllV算子时需要从设备侧内存获取send_list/receive_list参数信息,这需要进行一次设备到主机的数据传输操作,导致下发流程需要等待这一操作完成后才能继续下发其余算子。在正向计算中,这种断流会发生两次(token分发和聚合各一次),若考虑反向计算,断流次数将增加到四次,对整体性能造成严重影响。

昇思MindSpore通过其先进的异构计算能力,实现了AlltoAllV收发send_list/receive_list的异构复用。该技术的核心思想在于提前对token分发的send_list/receive_list进行设备到主机的数据传输,将其缓存在主机内存中,然后基于缓存的信息实现提前下发token聚合阶段的AlltoAllV。通过这一创新,成功将断流次数从四次降低到仅一次,在DeepSeek V3 671B实训测试中,端到端性能提升了5%。这一优化看似微小,但在持续数周甚至数月的大模型训练过程中,累积的效益十分可观。

除了上述两项关键技术外,昇思MindSpore的MoE性能优化方案还包含零冗余通信等多项创新技术,共同构筑了面向超大规模MoE训练的高效通信底座。这些技术不是孤立存在的,而是形成了一个有机的优化体系,从通信模式、内存管理、计算调度等多个维度协同提升训练效率。

昇思MindSpore的这一系列技术创新,反映了中国AI基础设施团队在前沿技术攻关上的深度与广度。随着全球AI竞争日益聚焦于底层技术能力,拥有自主可控、性能优异的AI框架和训练系统,已成为一个国家在人工智能领域保持竞争力的关键。昇思MindSpore作为国内领先的全场景AI框架,不仅在传统AI任务中表现出色,更在大模型训练这一前沿高地上持续突破,展现出中国在AI基础软件领域的坚实实力。

即将在杭州举办的昇思人工智能框架峰会,将邀请思想领袖、专家学者、企业领军人物及明星开发者等产学研用代表,共同探讨AI框架技术的发展趋势、分享创新成果与实践经验。峰会特别设置的昇思人工智能框架技术发展与行业实践论坛,将深入讨论昇思MindSpore大模型训练技术进展与实践,而MindSpore Parallel Training System SIG的核心贡献者更将在开发者动手实践workshop中,带领开发者亲身体验使用昇思MindSpore大模型训练技术。

在人工智能技术快速演进的今天,高效的训练系统已经成为释放大模型潜能的先决条件。昇思MindSpore在MoE性能优化上的突破,不仅为国内大模型研发提供了强有力的技术支撑,也为全球AI社区贡献了中国智慧。当更多的开发者和研究者能够基于高效、易用的AI框架开展创新工作,人工智能技术的发展将迎来更加繁荣的未来。随着昇思人工智能框架生态的不断完善,一个开放、协同、可持续的人工智能创新环境正在加速形成,为数字中国建设和全球人工智能发展注入新的动力。